Du interessierst Dich für das Thema semantische Suche bzw. semantische Suchmaschinen. Dann bist Du in unserem Glossar für Fachbegriffe aus dem (Online-) Marketing genau richtig. In diesem Beitrag bekommst Du alle wichtigen Informationen zum Thema semantische Suche.

Inhaltsverzeichnis

- 1 Was ist eine semantische Suchmaschine? Was ist semantische Suche?

- 2 Semantische Suche und Suchintention

- 3 Welche semantischen Suchmaschinen gibt es?

- 4 Die Rolle vom Knowledge Graph in der semantische Suche bei Google

- 5 Wie funktioniert Google als semantische Suchmaschine?

- 6 Durch Vektorraumanalysen und Machine Learning zum besseren semantischen Verständnis

- 7 Funktionalität und Einsatzgebiete von Natural Language Processing in modernen Suchmaschinen

- 8 Natural Language Processing zum Aufbau einer semantischen Wissensdatenbank

- 9 Sprachmodelle als Alternative zum klassischen Suche-Index und Knowledge Graph

- 10 Die Geschichte von Google als semantische Suchmaschine

- 11 FAQ zu semantischen Suchmaschinen

- 12 Weitere Quellen zur semantischen Suche

Was ist eine semantische Suchmaschine? Was ist semantische Suche?

Eine semantische Suchmaschine berücksichtigt den semantischen Kontext von Suchanfragen und Inhalten, um die Bedeutung besser zu verstehen.

Im Gegensatz zu rein Keyword basierten Such-Systemen soll in der semantischen Suche die Bedeutung der Suchanfrage und von Dokumenten besser interpretiert werden. Während Keyword basierte Suchmaschinen auf Grundlage eines Keyword-Text-Abgleich funktionieren, berücksichtigen semantische Suchmaschinen auch die Beziehungen zwischen Entitäten für die Ausgabe von Suchergebnissen.

Semantische Suche und Suchintention

Viele Definitionen, die man zur semantischen Suche findet, fokussieren sich auf die Interpretation der Suchintention als Wesen der semantischen Suche. Aber in erster Linie geht es bei der semantischen Suche um das Erkennen der Bedeutung von Suchanfragen und Inhalten anhand der vorkommenden Entitäten.

Semantik = Bedeutungslehre.

Bedeutung ist aber nicht gleich Intention.

Die Suchintention beschreibt die Erwartung, die ein Nutzer an die Suchergebnisse stellt. Die Bedeutung ist etwas anderes.

Die Identifikation der Bedeutung kann dabei helfen die Suchintention zu erkennen, ist aber eher ein Zusatznutzen der semantischen Suche.

Welche semantischen Suchmaschinen gibt es?

Es gibt eine Reihe semantischer Suchmaschinen, die allerdings relativ einfach funktionieren bzw. nur einen kleine Datenbestand verfügen.

Google ist die Suchmaschine mit dem größten semantischen Datenbestand in Form des Knowledge Graph und dem Knowledge Vault.

Die Rolle vom Knowledge Graph in der semantische Suche bei Google

Für eine Entitäten-basiertes Ranking bedarf es auch ein Entitäten basiertes Indexing. Der Knowledge Graph ist Googles Entitäten-Index, in dem Beziehungen zwischen den Entitäten berücksichtigt werden. Klassische Indizes sind in tabellarischer Form organisiert und lassen dadurch keine Abbildung der Beziehungen zwischen Datensätzen zu.

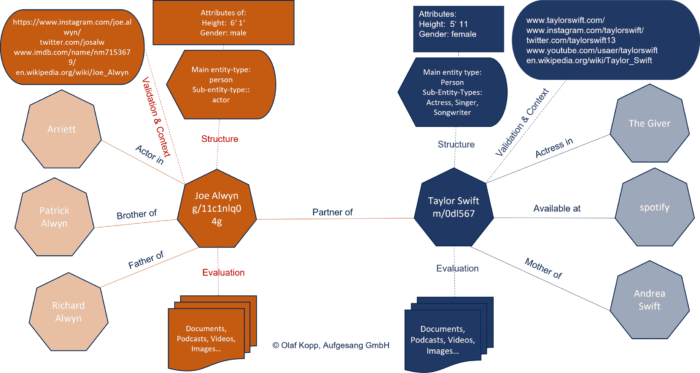

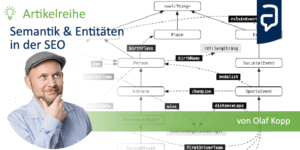

Ein Knowledge Graph ist eine semantische Datenbank, in der Informationen so strukturierte aufgearbeitet sind, dass aus den Informationen Wissen entsteht. In einem Knowledge Graph werden Entitäten (Knoten) über Kanten in Beziehung zueinander gestellt, mit Attributen und weiteren Informationen versehen und in thematischen Kontext bzw. Ontologien gebracht.

Entitäten sind das zentrale Organisations-Element in semantischen Datenbanken wir dem Knowledge Graph von Google.

Neben den Beziehungen zwischen den Entitäten sammelt Google über Data Mining Attribute und weitere Informationen zu den Entitäten und organisiert diese rund um die Entitäten.

Entitäten im Knowledge Graph

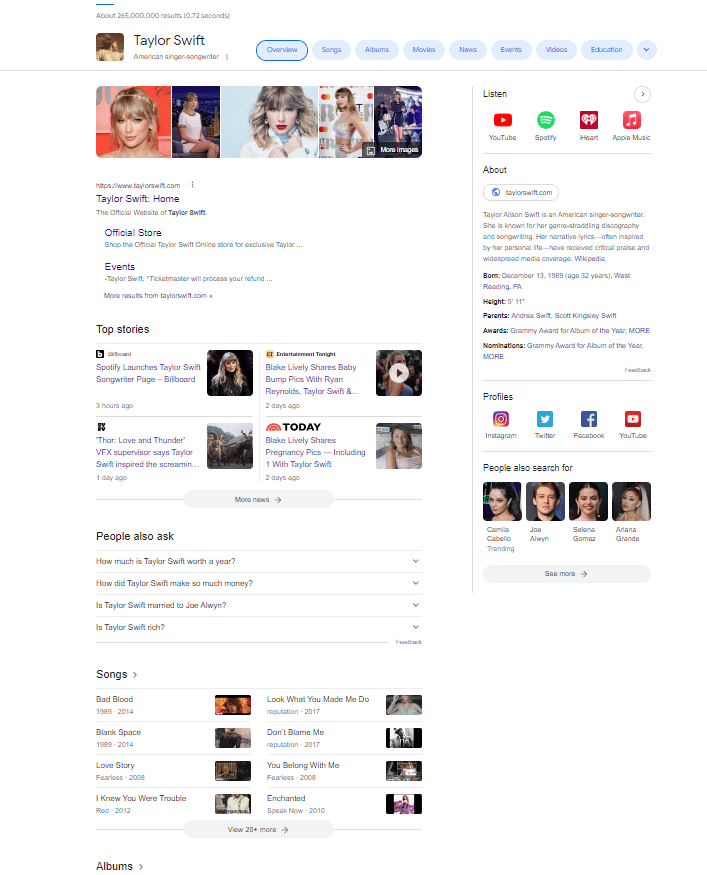

Wenn man nach einer Entität googlet bekommt man einen Eindruck davon welche Quellen und Informationen Google für eine Entität berücksichtigt.

SERPs zur Suchanfrage Taylor Swift

Die favorisierten Quellen, Attribute und Informationen variieren je nach Entitäten-Typ. Bei einer Personen-Entitäten sind diese anders als bei einer Event-Entität oder Organisations-Entität. Das ist auch entscheidend dafür welche Informationen in einem Knowledge Panel angezeigt werden.

Mehr zu den zentralen Organisations-Elementen rund um eine Entitäten-basierte Indexierung findest du im Beitrag „Alles was Du zu Entitäts-Typen, -Klassen & Attributen wissen solltest“.

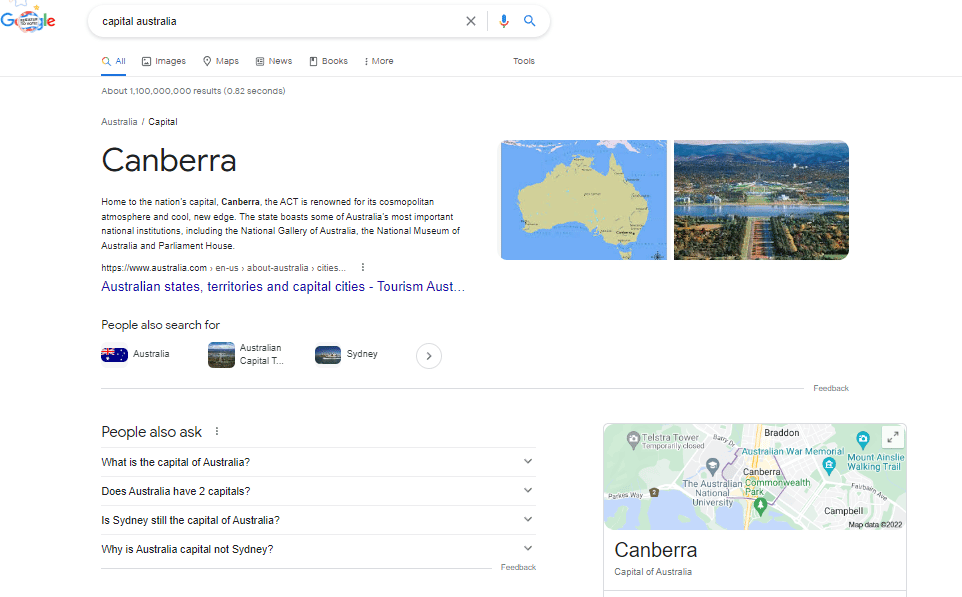

Die Struktur eines Entitäten-basierten Index erlaubt es Antworten auf Fragen zu geben, in denen ein Thema oder Entität gesucht wird, die in der Frage nicht genannt wird.

In diesem Beispiel sind „Australien“ und „Canberra“ die Entitäten und der Wert „Hauptstadt“ beschreibt die Art der Beziehung.

Eine Keyword-basierte Suchmaschine hätte diese Antwort nicht ausgeben können.

Als Grundlage für den Knowledge Graph dienen drei Ebenen:

- Entitäten-Katalog: Hier werden alle Entitäten gespeichert, die mit der Zeit identifiziert worden sind.

- Knowledge Repository: Die Entitäten werden in einem Wissensdepot (Knowledge Repository) mit den Informationen bzw. Attributen aus verschiedenen Quellen zusammengeführt. Im Knowledge Repository geht es in erster Linie um die Zusammenführung und Speicherung von Beschreibungen und die Bildung semantischer Klassen bzw. Gruppen in Form von Entitätstypen. Die Daten generiert Google über den Knowledge Vault. Über den Knowledge Vault ist es Google möglich, Data Mining aus unstrukturierten Quellen zu betreiben.

- Knowledge Graph: Im Knowledge Graph werden die Entitäten mit Attributen verknüpft und Beziehungen zwischen Entitäten hergestellt.

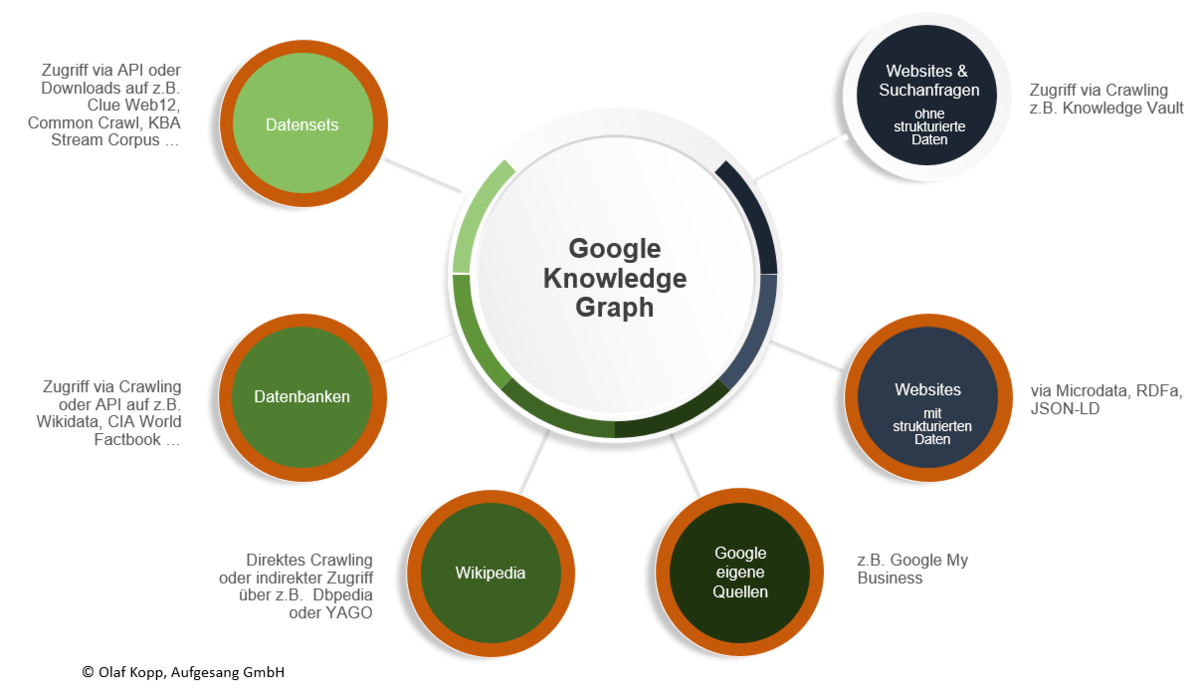

Für die Identifikation von Entitäten und der dazugehörigen Informationen kann Google auf verschiedene Quellen zurückgreifen.

Übersicht: Datenquellen für den Google Knowledge Graph

Mehr zum Thema „Erfassung von Informationen aus strukturierten Daten und Data Mining aus unstrukturierten Daten“ in den Beiträgen „Wie verarbeitet Google Informationen aus der Wikipedia für den Knowledge Graph?“ und „Wie kann Google aus unstrukturierten Inhalten Entitäten identifizieren und deuten?“.

Nicht alle im Knowledge Repository erfassten Entitäten werden in den Knowledge Graph übernommen. Folgende Kriterien könnten über die Aufnahmen in den Knowledge Graph entscheiden:

Generelle Kriterien:

- Nachhaltige gesellschaftliche Relevanz

- Genügend Suchtreffer für die Entität im Google-Index

- Anhaltende öffentliche Wahrnehmung

- Einträge in einem anerkannten Lexikon oder einer anerkannten Enzyklopädie bzw. in einem fachspezifischen Nachschlagewerk

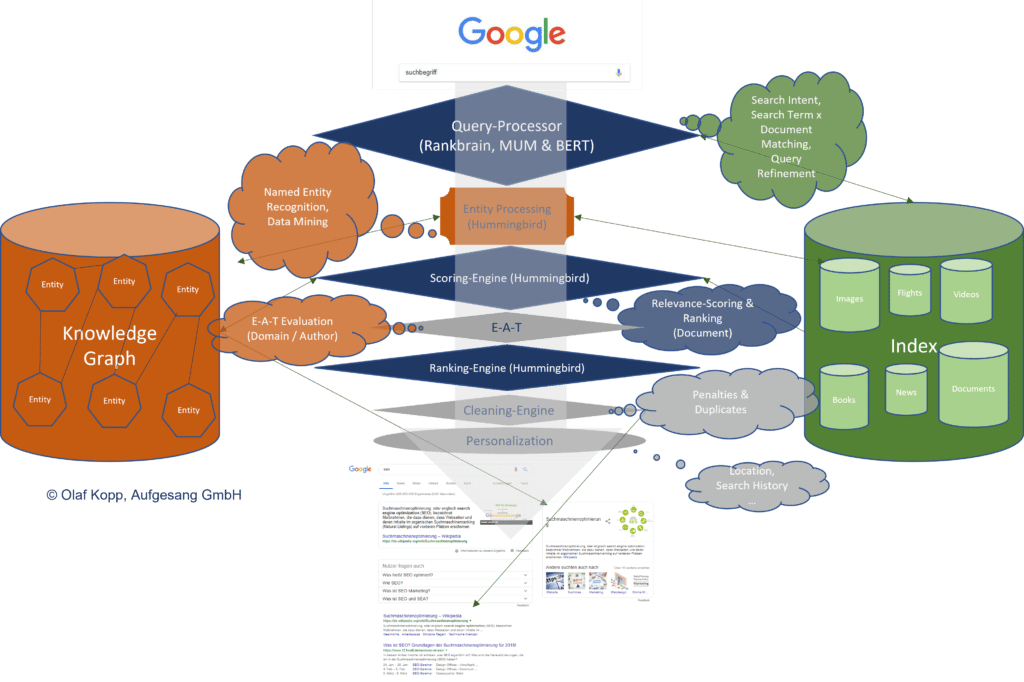

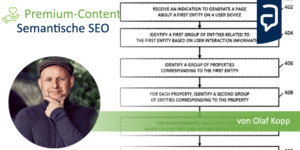

Wie funktioniert Google als semantische Suchmaschine?

Google nutzt die semantische Suche in den folgenden Bereichen:

- Verständnis von Suchanfragen bzw. Entitäten beim Search Query Processing

- Verstehen der Inhalte über Entitäten für das Ranking

- Verstehen der Inhalte und Entitäten für das Data Mining

- Kontextuelle Einordnung von Entitäten für eine spätere E-E-A-T-Bewertung

Die Google-Suche basiert heute auf einem Search-Query-Processor für die Interpretation von Suchanfragen und der Zusammenstellung von Korpussen aus für die Suchanfrage relevanten Dokumenten. Hier kommen wahrscheinlich BERT, MUM und Rankbrain zum Einsatz.

Im Search Query Processing werden die Suchterme mit den in den semantischen Datenbanken erfassten Entitäten abgeglichen, ggf. verfeinert oder umgeschrieben. Mehr zum Thema Search Query Processing erfahren.

Im nächsten Schritt wird die Suchintention bestimmt und ein passender Korpus aus x Inhalten ermittelt.

Dabei greift Google auf den klassischen Such-Index, als auch auf die eigene semantische Datenbank in Form des Knowledge Graph zurück. Es ist wahrscheinlich, dass zwischen diesen beiden Datenbanken ein Austausch über eine Schnittstelle stattfindet.

Eine Scoring Engine aus verschiedenen Algorithmen basierend auf dem Kern-Algorithmus von Hummingbird ist für das Scoring also die Bewertung der Inhalte zuständig und bringt diese dann anhand des Scorings in eine Reihenfolge. Bei dem Scoring geht es um die Relevanz eines Inhalts in Bezug auf die Suchanfrage bzw. Suchintention.

Da Google neben der Relevanz auch die Qualität von Inhalten bewerten möchte muss noch eine Bewertung nach E-E-A-T-Kriterien erfolgen. Welche Kriterien das sein könnten findest Du im Beitrag 20+ E-E-A-T-Bewertungs-Faktoren für das Ranking bei Google

Für diese E-E-A-T-Bewertung muss Google die Expertise, Autorität und Trustworthiness der Domain, des Publishers und/oder Autors bewerten. Hierfür können die semantischen Entitäten-Datenbanken die Grundlage sein.

Über eine Cleaning Engine werden diese Suchergebnisse dann von Duplikaten befreit und etwaige Abstrafungen berücksichtigt.

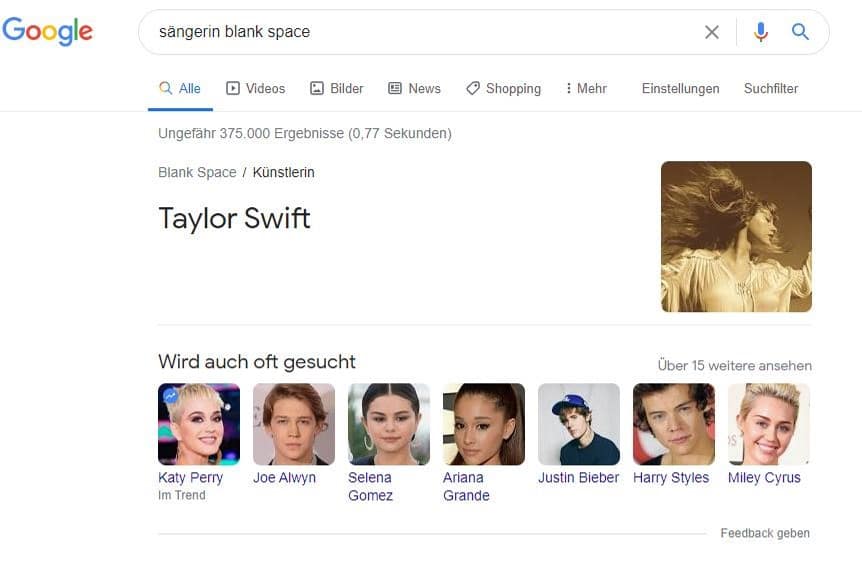

So kann Google die Bedeutung von Suchtermen identifizieren, ohne dass die eigentlichen Begriffe im Suchterm vorkommen. Die Suchanfrage nach „sängerin blank space“ ergibt folgendes Suchergebnis:

Knowledge Card für Taylor Swift

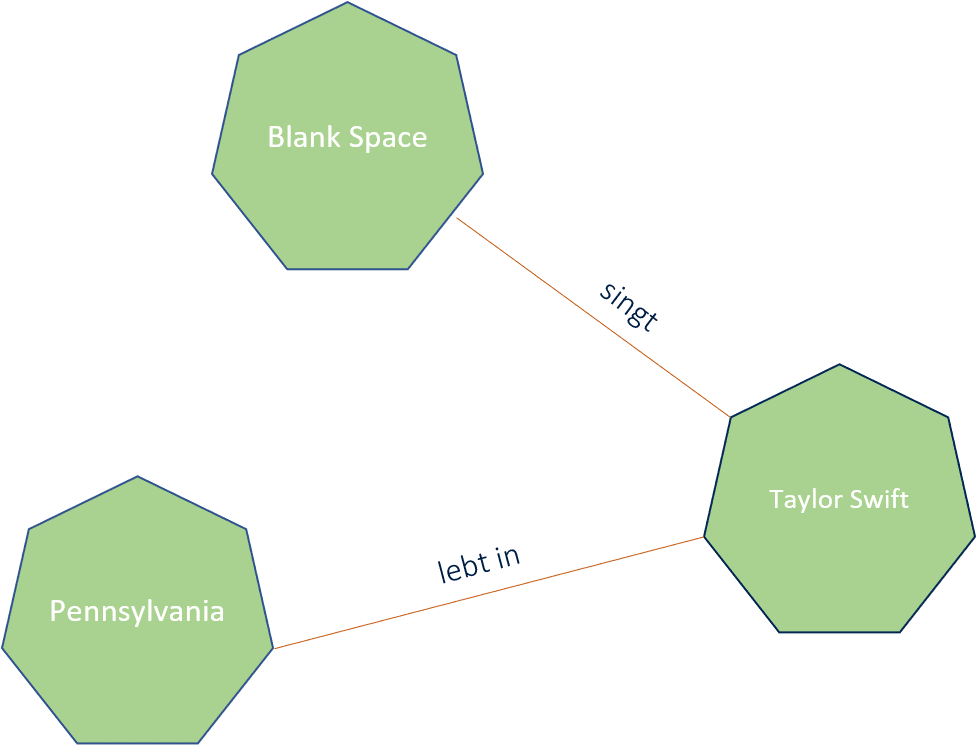

Diese Interpretation der Suchanfrage und Ausgabe der Informationen kann nur funktionieren, wenn die verschiedenen Entitäten aus dem Song Blank Space, der Personen-Entität Taylor Swift in Beziehung zueinander gesetzt werden können, was im Knowledge Graph von Google passiert.

Beziehungen im Google Knowledge Graph

Durch Vektorraumanalysen und Machine Learning zum besseren semantischen Verständnis

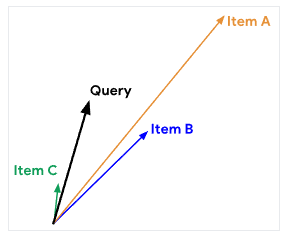

Durch Vektorraumanalysen lassen sich Suchanfragen und Inhalte in einen thematischen Kontext bringen. Man kann Entitäten, Inhalte oder Suchanfragen in einem Vektorraum verorten. Der Abstand der unterschiedlichen Begriffe zueinander gibt Auskunft über den thematischen Kontext in dem die Vektoren genutzt werden. Über diesen Weg lassen sich thematische Ontologien bzw. Kategorien ermitteln in dem Keywords bzw. Entitäten zu verorten sind.

Die Methodik Wörter als Vektoren maschinenlesbar zu transformieren (Word2Vec) hat Google 2015 mit Rankbrain offziell eingeführt, um insbesondere Suchanfragen besser zu verstehen. Rankbrain wurde als Innovation für das sogenannte Query Processing, also der Vorgang zur Interpretation von Suchanfragen, vorgestellt. Mit Rankbrain wurde auch das erste mal seitens Google bestätigt, dass Machine-Learning für die Google-Suche zum Einsatz kommt.

Funktionalität und Einsatzgebiete von Natural Language Processing in modernen Suchmaschinen

Mit der Einführung von BERT im Jahr 2018 gab es die offizielle Bestätigung von Google, dass sie Natural Language Processing für die Google-Suche nutzen. Beim Natural Language Processing als Teilbereich von Machine Learning geht es darum menschliche Sprache in geschriebener und gesprochener Form besser zu verstehen und unstrukturierte Informationen in maschinen lesbare strukturierte Daten umzuwandeln. Teilaufgaben von NLP sind Übersetzung von Sprachen und die Beantwortung von Fragen. Hier wird schnell klar wie wichtig diese Technologie für moderne Suchmaschinen wie Google ist.

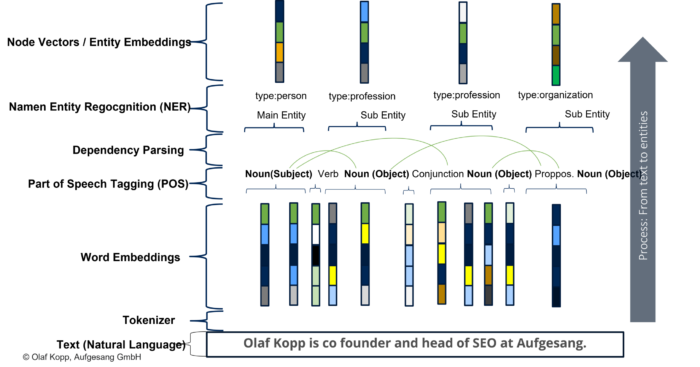

Generell kann man die Funktionsweise von NLP grob in die folgendenden Prozessschritte aufgliedern:

- Datenbereitstellung

- Datenvorbereitung

- Textanalyse

- Textanreicherung

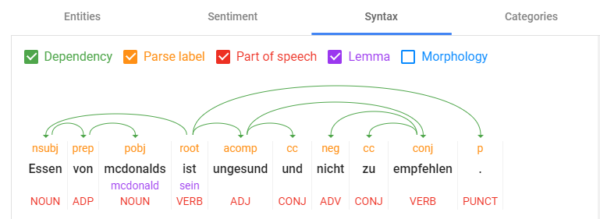

Die Kernkomponenten von NLP sind Tokenization zu deutsch Tokenisierung, Kennzeichnung von Wörtern nach Wortarten (Part of Speech Tagging), Lemmatisierung, Wort-Abhängigkeiten (Dependency Parsing), Parse Labeling, Extraktion von benannten Entitäten (Named Entity Recognition), Salience-Scoring, Sentiment-Analysen, Kategorisierung, Text-Klassifizierung, Extrahierung von Content-Typen und Identifikation einer impliziten Bedeutung aufgrund der Struktur.

- Tokenisierung: Tokenisierung ist der Vorgang, bei dem ein Satz in verschiedene Begriffe unterteilt wird.

- Kennzeichnung von Wörtern nach Wortarten: Wortartenkennzeichnung klassifiziert Wörter nach Wortarten wie z.B. Subjekt, Objekt, Prädikat, Adjektiv …

- Wortabhängigkeiten: Wortabhängigkeiten schafft Beziehungen zwischen den Wörtern basierend auf Grammatikregeln. Dieser Prozess bildet auch „Sprünge“ zwischen Wörtern ab.

- Lemmatisierung: Die Lemmatisierung bestimmt, ob ein Wort verschiedene Formen hat und normalisiert Abwandlungen zur Grundform,. Zum Beispiel ist die Grundform von Tiere, Tier oder von verspielt, Spiel.

- Parsing Labels: Die Kennzeichnung klassifiziert die Abhängigkeit oder die Art der Beziehung zwischen zwei Wörtern, die über eine Abhängigkeit verbunden sind.

- Analyse und Extraktion von benannten Entitäten: Dieser Aspekt sollte uns aus den vorangegangenen Beiträgen bekannt sein. Damit wird versucht, Wörter mit einer „bekannten“ Bedeutung zu identifizieren und Klassen von Entitätstypen zuzuordnen. Im Allgemeinen sind benannte Entitäten Menschen, Orte und Dinge (Substantive). Entitäten können auch Produktnamen enthalten. Dies sind im Allgemeinen die Wörter, die ein Knowledge Panel auslösen. Aber auch Begriffe, die kein eigenes Knowledge Panel auslösen können Entität sein.

Über Natural Language Processing können in Suchanfragen, Sätze und Textabschnitten Entitäten identifiziert sowie die einzelnen Bestandteile in sogenannte Tokens zerlegt werden und in Beziehung zueinander gesetzt werden. Auch ein grammatikalisches Verständnis kann durch NLP algorithmisch entwickelt werden.

Mit der Einführung von Natural Language Processing ist Google auch in der Lage mehr als nur die Substantive für die Interpretation von Suchanfragen, Texten und Sprache zu deuten. So sind seit BERT auch Verben, Adverbien, Adjektive für die Ermittlung des Kontext wichtig. Durch die Identifikation der Beziehungen zwischen den Tokens lassen sich Bezüge herstellen und so können auch Personalpronomen gedeutet werden.

Ein Beispiel:

„Olaf Kopp ist Head of SEO bei Aufgesang. Er beschäftigt sich seit 2005 mit Online-Marketing.“

In der Zeit vor Natural Language Processing konnte Google mit dem Personalpronomen „er“ nichts anfangen, da kein Bezug zur Entität „Olaf Kopp“ hergestellt werden konnte. Für die Indexierung und Ranking wurden nur die Begriffe Olaf Kopp, Head of SEO, Aufgesang, 2005 und Online Marketing berücksichtigt.

Über Natural Language Processing lassen sich nicht nur Entitäten in Suchanfragen und Inhalten identifizieren, sondern auch die Beziehung dieser zueinander.

Dabei wird die grammatikalische Satzstruktur, als auch Bezüge innerhalb von ganzen Absätzen und Texten berücksichtigt. Nomen bzw. Subjekt und Objekt in einem Satz können als potentielle Entitäten identifiziert werden. Über Verben lassen sich Beziehungen zwischen Entitäten herstellen. Durch Adjektive ein Sentiment (Stimmung) um eine Entität ermitteln.

Natural Language Processing über Vektoren

Über Natural Language Processing lassen sich auch konkrete W-Fragen besser beantworten, was für die Bedienung von Voice Search eine deutliche Weiterentwicklung darstellt.

Auch für das von Google 2021 eingeführte Passage Ranking spielt Natural Language Processing eine zentrale Rolle.

Seit der Einführung von BERT im Jahr 2018 nutzt Google diese Technologie in der Google-Suche. Das 2021 eingeführt Passage-Ranking basiert auf Natural Language Processing, da Google hier einzelne Textpassagen durch die neuen Möglichkeiten besser interpretieren kann.

Natural Language Processing zum Aufbau einer semantischen Wissensdatenbank

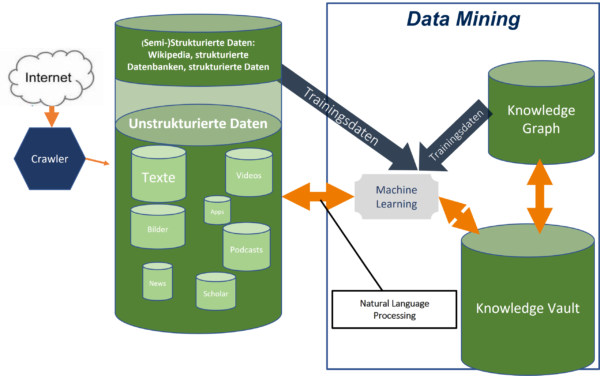

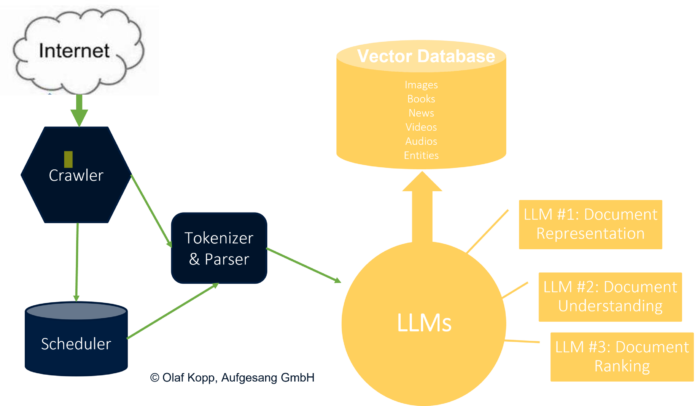

Während bis dato Google von manuell gepflegten strukturieren und semistrukturierten Informationen bzw. Datenbanken abhängig war ist es seit BERT möglich Entitäten und deren Beziehungen aus unstrukturierten Datenquellen zu extrahieren und in einem Graphen-Index zu speichern. Ein Quanten-Sprung in Sachen Data-Mining.

Dafür kann Google die bereits verifizierten Daten aus (semi-)strukturierten Datenbanken wie dem Knowledge Graph, Wikipedia … als Trainingsdaten nutzen, um zu lernen unstrukturierte Informationen zu bestehenden Modellen bzw. Klassen zuzuordnen und neue Muster zu erkennen. Hier spielt Natural Language Processing in Form von BERT und MUM die entscheidende Rolle.

Bereits 2013 hat Google erkannt, dass der Aufbau einer semantischen Datenbank wie dem Knowledge Graph ausschließlich basierend auf strukturiertem Daten zu langsam und nicht skalierbar möglich ist, da die große Masse an sogenannten Long-Tail-Entitäten nicht in (semi-)strukturierten Datenbanken erfasst sind. Zur Erfassung dieser Longtail-Entitäten bzw. des vollständigen Wissens der Welt stellt Google 2013 den Knowledge Vault vor, der aber seitdem nicht mehr groß Erwähnung fand. Der Ansatz über eine Technologie das komplette im Internet verfügbare Wissen für eine semantische Datenbank zu nutzen wird durch Natural Language Processing Realität. Es ist davon auszugehen, dass es neben dem Knowledge Graph eine Art Zwischenpeicher gibt in dem Google das über Natural Language Processing generierte Wissen zu erfassen und zu strukturieren bzw. organisieren. Sobald ein Validitäts-Schwellenwert erreicht werden die Entitäten und Informationen in den Knowledge Graph überführt. Dieser Zwischenspeicher könnte der Knowledge Vault sein.

Dadurch lässt sich auch erklären warum der Knowledge Graph gerade in den letzten Jahren sehr schnell gewachsen ist.

By mid-2016, Google reported that it held 70 billion facts and answered „roughly one-third“ of the 100 billion monthly searches they handled. By March 2023, this had grown to 800 billion facts on 8 billion entities.”, Quelle: https://en.wikipedia.org/wiki/Google_Knowledge_Graph

Sprachmodelle als Alternative zum klassischen Suche-Index und Knowledge Graph

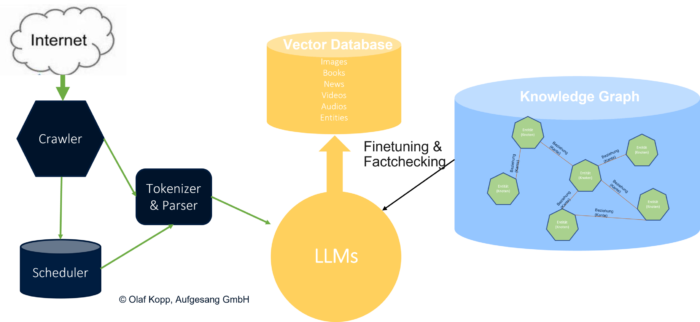

Der Aufstieg der Sprachmodelle kann für die Google-Suche einen fundamentalen Shift von klassischen Indizes zu Sprachmodellen führen, wie in der wissenschaftlichen Arbeit „Rethinking Search: Making Domain Experts out of Dilettantes“ vorgestellt. Der klassische Retrieve-and-Rank-Prozess wird verkürzt bzw. über Sprachmodelle durchgeführt. Entitäten, Inhalte, Textpassagen … können als Embeddings in einer Vektor-Datenbank gespeichert werden. Einzelne Tasks können neben einem generellen Sprachmodell in feinjustierten Sprachmodellen abgewickelt werden.

Das kann auch Auswirkungen auf die weitere Verwendung des Knowledge Graph als Entitäten-Speicher haben. Obwohl Sprachmodelle keine Wissensdatenbanken sind können sich zukünftige leistungsstärkere Sprachmodelle einem echten semantischen Verständnis und Wissen annähern. Knowledge Graphen könnten weiterhin beim Finetuning und Faktencheck unterstützen um semantische Beziehungen besser zu verstehen und das Risiko der Halluzinationen mindern.

Knowledge Graph im Zusammenspiel mit LLM

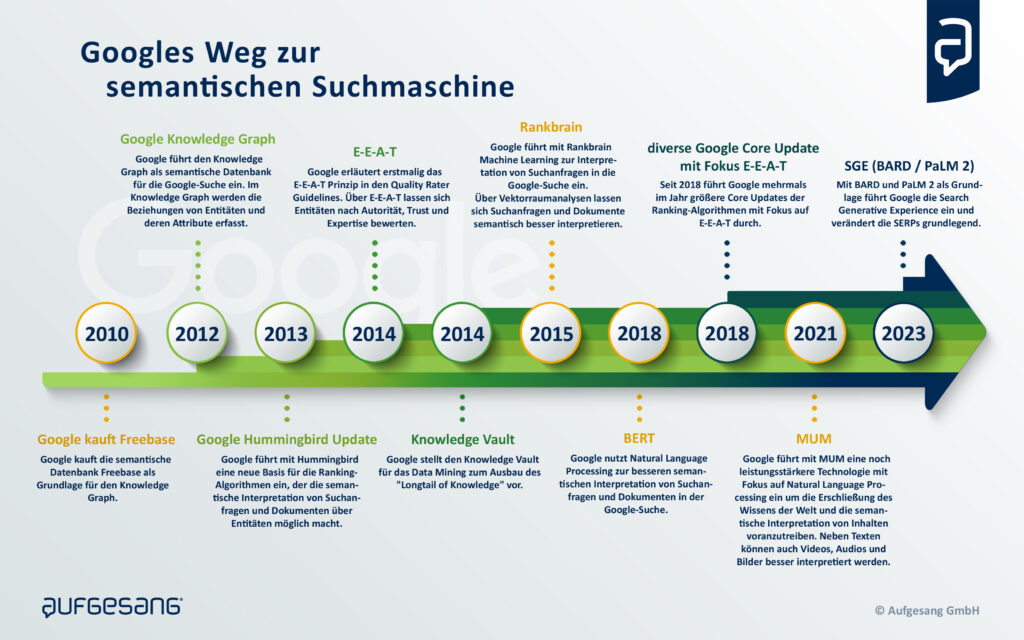

Die Geschichte von Google als semantische Suchmaschine

Hier eine Aufstellung der bedeutensten Innovationen, die Google seit 2010 auf dem Weg zur semantischen Suchmaschine eingeführt hat:

- 2010: Google kauft Freebase, eine vom Unternehmen Metaweb erstellte semantische Datenbank mit strukturierten maschinenlesbaren Daten zu Entitäten. Die erste Version den Knowledge Graph wurde durch Daten aus Freebase gespeist. 2014 wurde Freebase in das Projekt Wikidata übertragen. Von den ursprünglich ca. 10 Millionen Datensätzen aus Freebase wurde aber nur ein Teil übertragen.

- 2012: Google führt den Knowledge Graph in Form der Knowledge Panels und Knowledge Cards in die Suche ein. Ein Knowledge Graph ist eine Wissens-Datenbank, in der Informationen so strukturierte aufgearbeitet sind, dass aus den Informationen Wissen entsteht. Ein einem Knowledge Graph werden Entitäten (Knoten) über Kanten in Beziehung zueinander gestellt, mit Attributen versehen und in thematischen Kontext bzw. Ontologien gebracht. Dazu weiter unten in diesem Beitrag mehr oder hier >>> Google Knowledge Graph einfach erklärt

- 2013: Google stellt das Hummigbird-Update als neue Generation der Ranking-Algorithmen vor. Die Einführung von Hummingbird zum 15. Geburtstag von Google im Jahr 2013 war der endgültige Startschuss der semantischen Suche für Google. Google selbst hat dieses Algorithmus-Update als das bedeutenste seit dem Caffeine Update im Jahr 2010 bezeichnet. Es soll zur Einführung ca. 90% aller Suchanfragen betroffen haben und war im Vergleich zu Caffeine ein echtes Algorithmus-Update. Es soll dabei helfen komplexere Suchanfragen besser zu deuten und noch besser die eigentliche Suchintention bzw. Fragestellung hinter einer Suchanfrage zu erkennen sowie passende Dokumente dazu anzubieten. Auch auf Dokumentenebene soll die eigentliche Intention hinter dem Content besser mit der Suchanfrage gematcht werden. Mehr dazu >>> Was ist Google Hummingbird?

- 2014: Google stellt den Knowledge Vault vor. Ein System zur Identifikation und Extraktion von Tail-Entitäten, um den Ausbau des „Long Tail of Knowledge“ voranzutreiben. Über den Knowledge Vault ist es Google möglich, Data Mining aus unstrukturierten Quellen automatisiert zu betreiben und könnte die Grundlage für die nachfolgenden Innovationen in Sachen Natural Language Processing sein.

- 2014: Google führt E-A-T zur Bewertung von Websites in den Quality Rater Guidelines ein. Auf den ersten Blick ist die Brücke zur semantischen Suche nicht zu ziehen. Indirekt bietet das Entitäten-Konzept und Graphen-Konstrukt von semantischen Datenbanken aber eine ideale Grundlage für eine themenbezogen qualitative Bewertung von Entitäten (Publisher & Autoren) und deren Content hinsichtlich Expertise, Autorität und Trust. Ein Entitäten basierter Index macht es möglich Entitäten wie Autoren, Publisher, Marken, Domains … Ganzheitlich zu betrachten. Das gelingt nicht wenn man nur einzelne URLs, Bilder … betrachtet, wie die klassischen Google Indizes es tun. Mehr zu E-A-T >>>> E-A-T (Expertise, Autorität, Trust) erklärt Mehr zu den Google Quality Rater Guidelines >>> Die Google Quality Rater Guidelines & wichtigsten Erkenntnisse für SEO

- 2015: Google führt mit Rankbrain offiziell Machine Learning in die Google-Suche ein. Über Vektorraumanalysen will die Suchmaschine Suchanfragen und generell Begrifflichkeiten besser in eine Beziehung, thematische Nähe bzw. einen Kontext verorten. Dadurch können u.a. Suchanfragen hinsichtlich der Suchintention besser interpretiert werden.

- 2018: Google stellt BERT als neue Technologie für die bessere Interpretation von Suchanfragen und Texten vor. BERT nutzt Natural Language Processing um Suchanfragen, Sätze, Fragen, Textabschnitte und generell Content besser semantisch zu verstehen. Mehr zum Thema Natural Language Processing nachfolgend in diesem Beitrag oder hier >>> Natural Language Processing(NLP) einfach erklärt

- 2021: Google stellt MUM als neue Technologie für das bessere semantische Verständnis von Suchanfragen, Fragen, Content in verschiedenen Formen (Text, Video, Audio, Bild) und dem der Erschließung des „Wissens der Welt“ vor. Mit MUM kann Google die semantische(n) Datenbank(en) wie dem Knowledge Graph noch schneller und umfänglicher mit Informationen zu Entitäten erweitern.

- 2023: Unter dem öffentlichen Druck durch die Einführung von ChatGPT und die Einführung von KI-basierten Chatbot-Funktionalitäten bei Bing stellt Google BARD, das Sprachmodell PaLM 2 und eine Beta-Version der neuen Google-Suche SGE vor. Die Google-Suche entwickelt sich von einer Suchmaschine zu einer Antwortmaschine mit KI-generierten Antworten.

Nachfolgend das Ganze noch mal als Infografik zur freien Verwendung für z.B. Social Media.

Infografik semantische Suchmaschine Google, © Olaf Kopp, Aufgesang GmbH

FAQ zu semantischen Suchmaschinen

Wie semantisch ist die Google-Suche?

Aufgrund der Fortschritte, die Google in den letzten Jahren beim Deep-Learning gemacht hat ist davon auszugehen, dass das semantische Verständnis in der Zukunft sich exponentiell verbessert hat und weiter wird.

Warum ist ein semantisches Verständnis für Suchmaschinen so wichtig?

Durch semantische Methoden sind Suchmaschinen besser in der Lage die Bedeutung von Suchanfragen und deren Suchintention, als auch die Bedeutung von Dokumenten besser zu erkennen.

Welche Rolle spielen Entitäten in der semantischen Suche?

Entitäten sind das zentrale Element für semantische Suchmaschinen, um ein besseres Verständnis von Suchanfragen, Dokumenten und Websites zu bekommen.

Weitere Quellen zur semantischen Suche

- https://blog.searchmetrics.com/de/semantik-entitaeten-im-seo/

- https://blog.bloofusion.de/entitaten-sentiment-seo/

- https://www.jaeckert-odaniel.com/podcast/interview-olaf-kopp/

- https://www.termfrequenz.de/podcast/car-mar-om-podcast/entitaeten-bert-e-a-t-und-mitarbeiter-gast-olaf-kopp/

- https://www.websiteboosting.com/magazin/57/entitaeten-basierte-suche-so-funktioniert-der-google-knowledge-graph.html

- Die Google Suche: So funktioniert das Ranking der Suchmaschine heute - 13. Februar 2024

- Die 11 interessantesten Google-Patente aus dem Jahr 2023 und die Auswirkungen auf SEO - 30. November 2023

- Sind LLMO, GAIO oder GEO die Zukunft von SEO? - 4. Oktober 2023

- Googles Weg zur semantischen Suchmaschine - 29. Juni 2023

- Digital Authority Management: Eine neue Disziplin in Zeiten von SGE & E-E-A-T - 29. Juni 2023

Blog-Artikel zu diesem Thema

Die Google Suche: So funktioniert das Ranking der Suchmaschine heute

Google hat Informationen über seine Rankingsysteme veröffentlicht. Mit diesen Informationen, eigenen Überlegungen und Recherchen, z.B. in Google-Patenten und anderen Quellen, möchte ich in diesem Artikel die Puzzleteile zu einem Gesamtbild zusammenfügen.

Dabei gehe ich nicht im Detail auf di... Artikel anzeigen

Google hat Informationen über seine Rankingsysteme veröffentlicht. Mit diesen Informationen, eigenen Überlegungen und Recherchen, z.B. in Google-Patenten und anderen Quellen, möchte ich in diesem Artikel die Puzzleteile zu einem Gesamtbild zusammenfügen.

Dabei gehe ich nicht im Detail auf di... Artikel anzeigen

Googles Weg zur semantischen Suchmaschine

In diesem Beitrag möchte darauf eingehen welche Schritte und Innovationen Google seit 2010 näher an das Ziel des semantischen Verständnisses in der Suche gebracht haben. Es ist eine Zusammenfassung meiner Recherchen und Analysen seit 2013. Im Detail gehe ich auch auf die Rolle von Natural Languag... Artikel anzeigen

In diesem Beitrag möchte darauf eingehen welche Schritte und Innovationen Google seit 2010 näher an das Ziel des semantischen Verständnisses in der Suche gebracht haben. Es ist eine Zusammenfassung meiner Recherchen und Analysen seit 2013. Im Detail gehe ich auch auf die Rolle von Natural Languag... Artikel anzeigen

SEO-Aufgaben: Was macht ein SEO-Manager (m/w/d)?

Suchmaschinenoptimierung hat sich in den letzten Jahren deutlich verändert. Dadurch auch die Arbeit für SEO-Manager und SEO-Verantwortliche. In diesem Beitrag möchte ich eine Übersicht über die wichtigsten Aufgaben eines(einer) SEO-Managers/in bei der taktischen und strategischen Suchmaschineno... Artikel anzeigen

Suchmaschinenoptimierung hat sich in den letzten Jahren deutlich verändert. Dadurch auch die Arbeit für SEO-Manager und SEO-Verantwortliche. In diesem Beitrag möchte ich eine Übersicht über die wichtigsten Aufgaben eines(einer) SEO-Managers/in bei der taktischen und strategischen Suchmaschineno... Artikel anzeigen

20+ Faktoren für eine E-E-A-T-Bewertung durch Google

E-E-A-T hat sich durch die Core-Updates seit 2018 zu einem der wichtigsten Rankingeinflüsse für Google-Suchergebnisse entwickelt und wird durch die Einführung von SGE zusätzlich an Wichtigkeit gewinnen. In diesem Beitrag möchte ich auf 20+ Faktoren eingehen, die Google algorithmisch für eine E... Artikel anzeigen

E-E-A-T hat sich durch die Core-Updates seit 2018 zu einem der wichtigsten Rankingeinflüsse für Google-Suchergebnisse entwickelt und wird durch die Einführung von SGE zusätzlich an Wichtigkeit gewinnen. In diesem Beitrag möchte ich auf 20+ Faktoren eingehen, die Google algorithmisch für eine E... Artikel anzeigen

Brand-SEO: Suchmaschinenoptimierung für populäre Marken

Populäre Marken bzw. Brands leben in erster Linie von der Popularität der eigenen Marke(n). Eine bekannte Brand zu sein ist ein großes Asset und Marktvorteil, da Brands neben der Popularität oft auch ein großes Vertrauen genießen. Das ist ein Vorteil beim Abverkauf, für den Erfolg im Performa... Artikel anzeigen

Populäre Marken bzw. Brands leben in erster Linie von der Popularität der eigenen Marke(n). Eine bekannte Brand zu sein ist ein großes Asset und Marktvorteil, da Brands neben der Popularität oft auch ein großes Vertrauen genießen. Das ist ein Vorteil beim Abverkauf, für den Erfolg im Performa... Artikel anzeigen

Alles was Du als SEO zu Entitätstypen, -Klassen & Attributen wissen solltest

Es gibt nur wenige Informationen zu den wichtigen Elementen des Google Knowledge Graph wie Entitätstypen, -Klassen und -Attributen und Analyse der Beziehungen zwischen diesen Elementen. Ein Grund mehr im Rahmen meiner Artikelreihe zu semantischer Suchmaschinenoptimierung darauf einzugehen.

Vom Ent... Artikel anzeigen

Es gibt nur wenige Informationen zu den wichtigen Elementen des Google Knowledge Graph wie Entitätstypen, -Klassen und -Attributen und Analyse der Beziehungen zwischen diesen Elementen. Ein Grund mehr im Rahmen meiner Artikelreihe zu semantischer Suchmaschinenoptimierung darauf einzugehen.

Vom Ent... Artikel anzeigen

Wie versteht Google Suchanfragen durch Search Query Processing?

Dieser Beitrag meiner Artikelreihe zu Semantik und Entitäten in der SEO und bei Google beschäftigt sich mit der Rolle von Entitäten bei der Interpretation von Suchanfragen. Dabei werde ich auf einige Google Patente der letzten Jahre eingehen und daraus Ableitungen für das Search Query Processing... Artikel anzeigen

Dieser Beitrag meiner Artikelreihe zu Semantik und Entitäten in der SEO und bei Google beschäftigt sich mit der Rolle von Entitäten bei der Interpretation von Suchanfragen. Dabei werde ich auf einige Google Patente der letzten Jahre eingehen und daraus Ableitungen für das Search Query Processing... Artikel anzeigen

Entitäten-basierte Indexierung: Vom Content-Index zum Entitäten-Index

Die Basis für das Google-Ranking waren bis 2013 Websites, deren Content, Keywords und Backlinks. Mit dem Hummingbird-Update und dem Google Knowledge Graph startete Google die eigene Transformation zur semantischen Suchmaschine. Entitäten spielen bei dieser Transformation mit Blick auf die Indexier... Artikel anzeigen

Die Basis für das Google-Ranking waren bis 2013 Websites, deren Content, Keywords und Backlinks. Mit dem Hummingbird-Update und dem Google Knowledge Graph startete Google die eigene Transformation zur semantischen Suchmaschine. Entitäten spielen bei dieser Transformation mit Blick auf die Indexier... Artikel anzeigen

Indexierung und Darstellung von Medien in einem Entitäten-basierten Index

Im Juni 2021 hat Google ein interessantes Patent veröffentlicht, in dem ein Konzept vorgestellt wird wie eine Suchmaschine Medieninhalte rund um Haupt- und verwandten Medien-Entitäten in einem Index organisieren kann. Das Patent führt die Ansätze weiter, die ich bereits im Beitrag Entitäten-bas... Artikel anzeigen

Im Juni 2021 hat Google ein interessantes Patent veröffentlicht, in dem ein Konzept vorgestellt wird wie eine Suchmaschine Medieninhalte rund um Haupt- und verwandten Medien-Entitäten in einem Index organisieren kann. Das Patent führt die Ansätze weiter, die ich bereits im Beitrag Entitäten-bas... Artikel anzeigen

Wie schlau ist Google? Echtes semantisches Verständnis oder nur Statistik?

Dies ist der vierte Teil einer Beitragsreihe zum Thema semantische SEO und behandelt die Frage, ob Google wirklich die Bedeutung von Dokumenten und Suchanfragen versteht oder es doch nur statistische Analysen deutet.

Semantisches Verständnis als Ziel von Google

Eines der wichtigsten Ziele von Goo... Artikel anzeigen

Dies ist der vierte Teil einer Beitragsreihe zum Thema semantische SEO und behandelt die Frage, ob Google wirklich die Bedeutung von Dokumenten und Suchanfragen versteht oder es doch nur statistische Analysen deutet.

Semantisches Verständnis als Ziel von Google

Eines der wichtigsten Ziele von Goo... Artikel anzeigen

Die semantische Bedeutung von Keywords bei modernen Suchmaschinen

In modernen Suchmaschinen sind Keywords nicht mehr nur ein Mittel zum Zweck um einen Dokumenten-Suchanfragen-Abgleich durchzuführen. Keywords sind vor allem dazu da ein semantisches Verständnis sowohl des Suchterms als auch eines Dokuments/Inhalts zu entwickeln. Basierend auf einem Google-Patent m... Artikel anzeigen

In modernen Suchmaschinen sind Keywords nicht mehr nur ein Mittel zum Zweck um einen Dokumenten-Suchanfragen-Abgleich durchzuführen. Keywords sind vor allem dazu da ein semantisches Verständnis sowohl des Suchterms als auch eines Dokuments/Inhalts zu entwickeln. Basierend auf einem Google-Patent m... Artikel anzeigen

Die Rolle von Natural Language Processing für Data Mining, Entitäten & Suchanfragen

In diesem Beitrag werde ich mich tiefer mit Natural Language Processing (kurz NLP) für Data Mining und speziell für den Knowledge Graph und Suchmaschinen beschäftigen. Zum Anfang möchte ich in die Grundlagen von Natural Language Processing einsteigen.

Eine ausführliche Beitragssammlung zum T... Artikel anzeigen

In diesem Beitrag werde ich mich tiefer mit Natural Language Processing (kurz NLP) für Data Mining und speziell für den Knowledge Graph und Suchmaschinen beschäftigen. Zum Anfang möchte ich in die Grundlagen von Natural Language Processing einsteigen.

Eine ausführliche Beitragssammlung zum T... Artikel anzeigen

Wie erstellt Google Knowledge Panel & Knowledge Cards?

Die Präsenz von SERP-Features wie Knowledge Panel und Knowledge Cards in den SERPs von Google steigt seit Jahren rasant an. Dadurch bekommen die klassischen Suchergebnisse auch "Blue Links" genannt immer mehr Konkurrenz, wenn es um die Aufmerksamkeit der Suchenden geht. Oder nennen wir es besser di... Artikel anzeigen

Die Präsenz von SERP-Features wie Knowledge Panel und Knowledge Cards in den SERPs von Google steigt seit Jahren rasant an. Dadurch bekommen die klassischen Suchergebnisse auch "Blue Links" genannt immer mehr Konkurrenz, wenn es um die Aufmerksamkeit der Suchenden geht. Oder nennen wir es besser di... Artikel anzeigen

Video: Entitäten basierte Suche – Alles zum Knowledge Graph, NLP, Ranking, E A T und Semantik in der SEO

Im April 2020 habe ich für den OMT ein knapp zweistündiges Webinar zum Thema Semantische Suche bzw. Entitäten basierte Suche gehalten. Ich beschreibe ausführlich den Zusammenhang zwischen Knowledge-Graph, Data-Mining via Natural-Language-Processing und wie das Ganze mit E-A-T und digitalen Marke... Artikel anzeigen

Im April 2020 habe ich für den OMT ein knapp zweistündiges Webinar zum Thema Semantische Suche bzw. Entitäten basierte Suche gehalten. Ich beschreibe ausführlich den Zusammenhang zwischen Knowledge-Graph, Data-Mining via Natural-Language-Processing und wie das Ganze mit E-A-T und digitalen Marke... Artikel anzeigen

Aufzeichnung: Semantische Suche bei Google – SEO/SEA World Conference / Internet World

Aufzeichnung meines Vortrags auf der SEO/SEA World Conference 2021 präsentiert von der Internet World.

Google entwickelt sich seit der Einführung des Knowledge Graph und Hummingbird immer mehr zu einer semantischen Suchmaschine. Die Einführung von DeepRank (BERT) und MUM hat diesen Prozess z... Artikel anzeigen

Aufzeichnung meines Vortrags auf der SEO/SEA World Conference 2021 präsentiert von der Internet World.

Google entwickelt sich seit der Einführung des Knowledge Graph und Hummingbird immer mehr zu einer semantischen Suchmaschine. Die Einführung von DeepRank (BERT) und MUM hat diesen Prozess z... Artikel anzeigen

Wie kann Google aus unstrukturierten Inhalten Entitäten identifizieren und deuten?

Wie im letzten Beitrag Wie verarbeitet Google Informationen aus der Wikipedia für den Knowledge Graph? erläutert gibt es bei Wissens-Datenbanken wie dem Knowledge Graph die herausfordernde Aufgabe Vollständigkeit und Richtigkeit der Informationen in Balance zu halten. Eine notwendige Voraussetzun... Artikel anzeigen

Wie im letzten Beitrag Wie verarbeitet Google Informationen aus der Wikipedia für den Knowledge Graph? erläutert gibt es bei Wissens-Datenbanken wie dem Knowledge Graph die herausfordernde Aufgabe Vollständigkeit und Richtigkeit der Informationen in Balance zu halten. Eine notwendige Voraussetzun... Artikel anzeigen

Wie verarbeitet Google Informationen aus der Wikipedia für den Knowledge Graph?

Die größte Herausforderung für Google mit Blick auf eine semantische Suche stellt das Identifizieren und Extrahieren von Entitäten und deren Attributen aus Datenquellen wie Websites dar. Die Informationen sind meistens nicht strukturiert und nicht fehlerfrei. Der aktuelle Knowledge Graph als Goo... Artikel anzeigen

Die größte Herausforderung für Google mit Blick auf eine semantische Suche stellt das Identifizieren und Extrahieren von Entitäten und deren Attributen aus Datenquellen wie Websites dar. Die Informationen sind meistens nicht strukturiert und nicht fehlerfrei. Der aktuelle Knowledge Graph als Goo... Artikel anzeigen

Entitäten & E-A-T: Die Rolle von Entitäten bei Autorität und Trust

Dieser Beitrag beschreibt den Zusammenhang zwischen Entitäten und Expertise, Autorität und Vertrauen bzw. der E-A-T-Bewertung von Autoren, Publishern und Unternehmen.

Autoren, Unternehmen und Publisher als Entitäten

Inhalte werden durch Personen wie Autoren und Organisationen wie Unternehmen, V... Artikel anzeigen

Dieser Beitrag beschreibt den Zusammenhang zwischen Entitäten und Expertise, Autorität und Vertrauen bzw. der E-A-T-Bewertung von Autoren, Publishern und Unternehmen.

Autoren, Unternehmen und Publisher als Entitäten

Inhalte werden durch Personen wie Autoren und Organisationen wie Unternehmen, V... Artikel anzeigen

E-A-T-Optimierung: Wie optimiert man E-A-T bei Google?

E-A-T ist seit den Core-Updates in den letzten Jahren im Fokus der Suchmaschinenoptimierung. Antworten auf die Fragen warum E-A-T so wichtig für das Ranking ist, welche möglichen Signale Google für die Bewertung nutzt und wie man darauf optimiert gibt es in diesem Beitrag.

Was ist E-A-T überhau... Artikel anzeigen

E-A-T ist seit den Core-Updates in den letzten Jahren im Fokus der Suchmaschinenoptimierung. Antworten auf die Fragen warum E-A-T so wichtig für das Ranking ist, welche möglichen Signale Google für die Bewertung nutzt und wie man darauf optimiert gibt es in diesem Beitrag.

Was ist E-A-T überhau... Artikel anzeigen

Wie kann Google über Entitäten, NLP & Vektorraumanalysen relevante Dokumente identifizieren und ranken?

Dieser Beitrag meiner Artikelreihe zu Semantik und Entitäten in der SEO beschäftigt sich damit wie Google für Suchanfragen mit Entitäten-Bezug u.a. über Natural Language Language Processing und Vektorraumanalysen passende Inhalte identifiziert und rankt. Dazu habe ich über 20 Google-Patente un... Artikel anzeigen

Dieser Beitrag meiner Artikelreihe zu Semantik und Entitäten in der SEO beschäftigt sich damit wie Google für Suchanfragen mit Entitäten-Bezug u.a. über Natural Language Language Processing und Vektorraumanalysen passende Inhalte identifiziert und rankt. Dazu habe ich über 20 Google-Patente un... Artikel anzeigen

Google MUM Update: Was erwartet SEOs in der Zukunft?

In diesem Beitrag gehe ich auf das Google MUM-Update ein, dass Google 2021 vorgestellt hat. Ich gehe auf die Neuigkeiten ein, die auf die Suchmaschinen-Nutzer und SEOs in den nächsten Jahren durch MUM zukommen werden. Zudem gehe ich darauf ein wie SEOs und Webmaster darauf vorbereiten können.

Was... Artikel anzeigen

In diesem Beitrag gehe ich auf das Google MUM-Update ein, dass Google 2021 vorgestellt hat. Ich gehe auf die Neuigkeiten ein, die auf die Suchmaschinen-Nutzer und SEOs in den nächsten Jahren durch MUM zukommen werden. Zudem gehe ich darauf ein wie SEOs und Webmaster darauf vorbereiten können.

Was... Artikel anzeigen

Indexierung und SERP-Auslieferung nach Themen bzw. Entitäten

Dieser Beitrag beschäftigt sich mit einem Google Patent aus Juni 2021, in dem Methoden beschrieben werden wie eine Suchmaschine Content bestimmten Entitäten / Themen zuordnet und in ein Ranking überführt. Interessant ist dieser Beitrag für fortgeschrittene SEOs, Content-Verantwortliche und Lehr... Artikel anzeigen

Dieser Beitrag beschäftigt sich mit einem Google Patent aus Juni 2021, in dem Methoden beschrieben werden wie eine Suchmaschine Content bestimmten Entitäten / Themen zuordnet und in ein Ranking überführt. Interessant ist dieser Beitrag für fortgeschrittene SEOs, Content-Verantwortliche und Lehr... Artikel anzeigen

Kontextuelle Suche für Multimedia-Content

Dieser Beitrag fasst Methoden aus einem Google-Patent für die kontextuelle Suche angewandt auf Multimedia-Content wie z.B. Videos oder Podcasts zusammen. Der Beitrag ist interessant für SEOs und Content-Verantwortliche.

Zusammenfassung des Patents „Contextual Search on multimedia content“

Da... Artikel anzeigen

Dieser Beitrag fasst Methoden aus einem Google-Patent für die kontextuelle Suche angewandt auf Multimedia-Content wie z.B. Videos oder Podcasts zusammen. Der Beitrag ist interessant für SEOs und Content-Verantwortliche.

Zusammenfassung des Patents „Contextual Search on multimedia content“

Da... Artikel anzeigen

Youtube: Interpretation und Ranking von Videos via Entitäten

Dieser Beitrag beschäftigt sich mit einem Google Patent aus Dezember 2021, in dem Methoden beschrieben werden wie eine Suchmaschine Entitäten in einem Video z.B. bei Youtube erkennen kann. Aufgrund von Features, die man bereits in der Google-Suche und bei Youtube vorfindet ist es sehr wahrscheinli... Artikel anzeigen

Dieser Beitrag beschäftigt sich mit einem Google Patent aus Dezember 2021, in dem Methoden beschrieben werden wie eine Suchmaschine Entitäten in einem Video z.B. bei Youtube erkennen kann. Aufgrund von Features, die man bereits in der Google-Suche und bei Youtube vorfindet ist es sehr wahrscheinli... Artikel anzeigen

Wie Google Fragen auf Basis unstrukturierter Daten beantworten kann

Ein neues Google-Patent aus November 2021 hat meine Aufmerksamkeit erweckt. In ihm wird beschrieben, wie Google in natürlicher Sprache gestellte Fragen basierend auf Entitäten-Referenzen aus unstrukturierten Informationen erkennen und ranken kann. Viel Spass beim Lesen!

Das Google-Patent

Das Goo... Artikel anzeigen

Ein neues Google-Patent aus November 2021 hat meine Aufmerksamkeit erweckt. In ihm wird beschrieben, wie Google in natürlicher Sprache gestellte Fragen basierend auf Entitäten-Referenzen aus unstrukturierten Informationen erkennen und ranken kann. Viel Spass beim Lesen!

Das Google-Patent

Das Goo... Artikel anzeigen

Personalisierung und Darstellung von Informationen zu einer Entität

Dieser Beitrag beschäftigt sich mit einem Google-Patent, das im Februar 2021 von Google beansprucht wurde. Es beschreibt wie Google Informationen zu Entitäten dynamisch zur Suchintention ausliefern kann. Dieser Beitrag gehört zur Artikelreihe Semantische SEO: Entitäten, NLP & Semantik bei ... Artikel anzeigen

Dieser Beitrag beschäftigt sich mit einem Google-Patent, das im Februar 2021 von Google beansprucht wurde. Es beschreibt wie Google Informationen zu Entitäten dynamisch zur Suchintention ausliefern kann. Dieser Beitrag gehört zur Artikelreihe Semantische SEO: Entitäten, NLP & Semantik bei ... Artikel anzeigen

Das Internet als Datengraph und wie Google daraus Informationen zu Entitäten extrahiert

Dieser Beitrag ist eine Übersetzung des Originals THE WEB AS A DATA GRAPH IS A NEW DIRECTION FOR SEO von Bill Slawski.

Viele der Artikel, die Leute über SEO schreiben, haben mit Webseiten und Links zwischen Seiten zu tun, aber in diesem Beitrag geht es um

Entitäten und Beziehungen zwisc... Artikel anzeigen

Dieser Beitrag ist eine Übersetzung des Originals THE WEB AS A DATA GRAPH IS A NEW DIRECTION FOR SEO von Bill Slawski.

Viele der Artikel, die Leute über SEO schreiben, haben mit Webseiten und Links zwischen Seiten zu tun, aber in diesem Beitrag geht es um

Entitäten und Beziehungen zwisc... Artikel anzeigen

Knowledge Graph für alle: Google führt personenbezogene Search Profile Cards ein

Die semantische Suche hält mit großen Schritten Einzug bei Google. Die Search Profile Cards erlauben unabhängig von Wikipedia und Einträgen bei Wikidata Personen sich als Entität bei Google zu registrieren.

Die Search Cards als Eintritt in den Knowledge Graph für jedermann

Meine Vermutung is... Artikel anzeigen

Die semantische Suche hält mit großen Schritten Einzug bei Google. Die Search Profile Cards erlauben unabhängig von Wikipedia und Einträgen bei Wikidata Personen sich als Entität bei Google zu registrieren.

Die Search Cards als Eintritt in den Knowledge Graph für jedermann

Meine Vermutung is... Artikel anzeigen

Das semantische Web (Web 3.0) als logische Konsequenz aus dem Web 2.0

Die Entwicklung hin zum semantischen Web verändert die Priorisierung und Auslieferung von Informationen durch die wichtigsten Gatekeeper im Netz und damit auch das Online-Marketing. Nachfolgend ein Erklärungsansatz.

Das Web 3.0 als logische Konsequenz aus dem Web 2.0

Das Web 2.0 m... Artikel anzeigen

Die Entwicklung hin zum semantischen Web verändert die Priorisierung und Auslieferung von Informationen durch die wichtigsten Gatekeeper im Netz und damit auch das Online-Marketing. Nachfolgend ein Erklärungsansatz.

Das Web 3.0 als logische Konsequenz aus dem Web 2.0

Das Web 2.0 m... Artikel anzeigen

Semantische Themen finden: Wie identifiziert man semantisch verwandte Keywords?

Das semantische Web oder auch Web 3.0 genannt hält Einzug bei den wichtigsten Traffic-Verteilern im Netz wie Google und Facebook. Semantische Beziehungen zwischen Themen spielen insbesondere für Google eine wichtige Rolle, um thematische Relevanz von Websites und Dokumenten zu ermitteln. Nachfolg... Artikel anzeigen

Das semantische Web oder auch Web 3.0 genannt hält Einzug bei den wichtigsten Traffic-Verteilern im Netz wie Google und Facebook. Semantische Beziehungen zwischen Themen spielen insbesondere für Google eine wichtige Rolle, um thematische Relevanz von Websites und Dokumenten zu ermitteln. Nachfolg... Artikel anzeigen

Happy Hash-Tagging bei Google! Semantische Verbindung von Inhalten und Entitäten

Das #Hashtag ist ein Internetdings mit einer wichtigen Funktion. Es dient der Verschlagwortung von Inhalten und kann als solches ein wenig Ordnung in die digitale Informationsflut bringen. Wobei „Ordnung“ relativ gemeint ist.

Man könnte sie eher als eine Art roten Faden im Informationsch... Artikel anzeigen

Das #Hashtag ist ein Internetdings mit einer wichtigen Funktion. Es dient der Verschlagwortung von Inhalten und kann als solches ein wenig Ordnung in die digitale Informationsflut bringen. Wobei „Ordnung“ relativ gemeint ist.

Man könnte sie eher als eine Art roten Faden im Informationsch... Artikel anzeigen

Branding & das neue Google Ranking: Warum SEO nicht mehr reicht…

Das Etablieren einer Marke wird zukünftig eine immer wichtigeree Rolle beim Ranking von Inhalten spielen. Warum die Suchmaschinenoptimierung (SEO) bei der Beeinflussung der Suchmaschinen-Rankings nur noch eine Aufgabe dabei ist und Marketing immer wichtiger erläutere ich nachfolgend.

&n... Artikel anzeigen

Das Etablieren einer Marke wird zukünftig eine immer wichtigeree Rolle beim Ranking von Inhalten spielen. Warum die Suchmaschinenoptimierung (SEO) bei der Beeinflussung der Suchmaschinen-Rankings nur noch eine Aufgabe dabei ist und Marketing immer wichtiger erläutere ich nachfolgend.

&n... Artikel anzeigen

Google achtet jetzt auf innere Werte

2013 hat Google sich zum 15. Geburtstag ein ganz besonderes Geschenk gemacht. Die Suchmaschine hat einen Vogel, einen Kolibri, um genau zu sein und der wirbelt den Tiergarten nicht nur farblich auf. Es handelt sich dabei nämlich nicht um ein Anti-Spam-Update á la Panda oder Pinguin, mit dem die S... Artikel anzeigen

2013 hat Google sich zum 15. Geburtstag ein ganz besonderes Geschenk gemacht. Die Suchmaschine hat einen Vogel, einen Kolibri, um genau zu sein und der wirbelt den Tiergarten nicht nur farblich auf. Es handelt sich dabei nämlich nicht um ein Anti-Spam-Update á la Panda oder Pinguin, mit dem die S... Artikel anzeigen